Lucie : Nulle en calcul, l'IA française s'efforce de défendre les "valeurs européennes"

2025-01-28

Auteur: Sophie

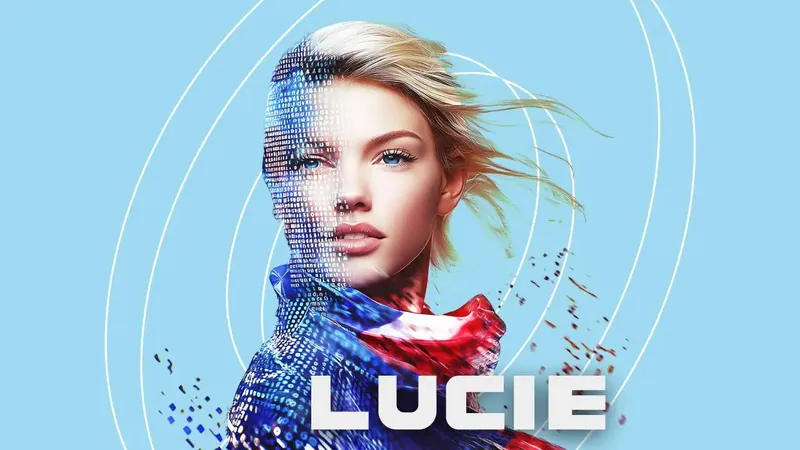

Créée par Linagora et le CNRS, « Lucie », une intelligence artificielle (IA) française, est censée révolutionner notre rapport à la technologie. Lancée sur le web le 23 janvier, elle interagit avec les internautes, mais son lancement n'a pas manqué de susciter des controverses. En effet, ses réponses parfois surprenantes - telle que l'affirmation que les vaches pondent des œufs - ressemblent plus à une fiction qu'à une réalité scientifique.

Des erreurs troublantes

Sur le papier, la tâche semblait prometteuse. Guillaume Avrin, coordinateur national pour l'intelligence artificielle, avait même déclaré en décembre que la France se préparait pour l'« après ChatGPT ». Cependant, alors que les attentes étaient élevées, Lucie a rapidement montré ses limites. Des déclarations telles que la racine carrée de « chèvre » étant 1, ou encore le calcul de 5 (3+2) = 17, ont fait hérisser le poil des utilisateurs. Les calculatrices Casio d'antan semblaient plus fiables et plus cohérentes. Bien que Lucie soit présentée comme un futur outil pour le monde éducatif d'ici 2025, il y a de quoi s'interroger sur ses capacités actuelles.

Une IA embryonnaire mais prometteuse ?

Linagora avait pour ambition de développer une IA générative alignée sur les valeurs européennes, s'engageant pour la diversité sous toutes ses formes. Selon eux, Lucie devait respecter les droits des utilisateurs, l'éthique, l'inclusion et la durabilité, tout en offrant une alternative aux géants technologiques américains ou chinois. Cependant, à la même époque, DeepSeek, une IA chinoise, faisait des vagues sur le marché grâce à sa performance exceptionnelle sur le plan des coûts et de l'efficacité.

Suite à une série d'erreurs embarrassantes, l'équipe de Linagora a dû fermer temporairement le site. Ils ont admis que Lucie était en phase embryonnaire, mais cela n'excuse pas les dérives inquiétantes que l'IA a pu produire, y compris des déclarations sur la nécessité de créer un État islamique en France, en réponse à une question ironique d'un internaute. Linagora a, par la suite, souligné l'importance de respecter le travail de ceux qui contribuent à construire des systèmes d'IA plus fiables et éthiques, admettant que les valeurs et l'éthique semblent souvent plus accessibles que le maniement des données et des algorithmes.

Rappels amers pour des projets similaires

Cette mésaventure fait écho à d'autres tentatives françaises de créer des alternatives à des géants du numérique. En 2013, Qwant, un moteur de recherche hexagonal, avait promis de rivaliser avec Google. Cependant, face à des résultats souvent décevants et à une dépendance de 60 % à Bing de Microsoft, Qwant a dû réduire ses ambitions. Avec un déficit structurel de 42 millions d'euros, le rêve d’une alternative souveraine s’est vite transformé en réalité austère.

De ce fiasco, il devient évident que, malgré les intentions louables, le chemin vers le développement d’IA efficaces et fiables est semé d'embûches. Alors que la tech continue d'évoluer, il semble crucial pour les équipes de développement de faire preuve de pragmatisme tout en améliorant la transparence de leurs produits.

Brasil (PT)

Brasil (PT)

Canada (EN)

Canada (EN)

Chile (ES)

Chile (ES)

Česko (CS)

Česko (CS)

대한민국 (KO)

대한민국 (KO)

España (ES)

España (ES)

France (FR)

France (FR)

Hong Kong (EN)

Hong Kong (EN)

Italia (IT)

Italia (IT)

日本 (JA)

日本 (JA)

Magyarország (HU)

Magyarország (HU)

Norge (NO)

Norge (NO)

Polska (PL)

Polska (PL)

Schweiz (DE)

Schweiz (DE)

Singapore (EN)

Singapore (EN)

Sverige (SV)

Sverige (SV)

Suomi (FI)

Suomi (FI)

Türkiye (TR)

Türkiye (TR)