Meta-KI: Neue Llama-4-Modelle sind extrem effizient – aber nicht für EU-Nutzer verfügbar

2025-04-06

Autor: Mia

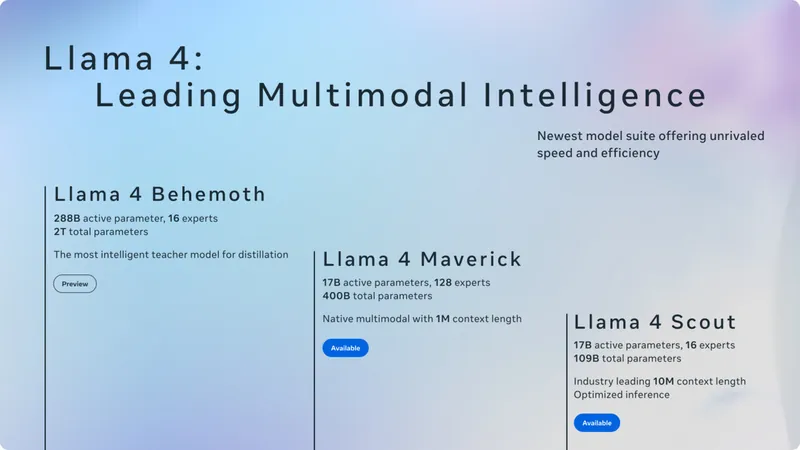

Meta hat mit Maverick und Scout die ersten zwei Llama-4-Modelle vorgestellt, die als multimodale Modelle fungieren. Diese Modelle sind zwar nicht mit ausgeprägten Reasoning-Fähigkeiten ausgestattet, zeichnen sich jedoch durch ihre hohe Effizienz aus.

Llama 4 Maverick verfügt über beeindruckende 17 Milliarden aktive Parameter bei insgesamt 400 Milliarden Parametern, während Llama 4 Scout ebenfalls 17 Milliarden aktive Parameter hat, jedoch mit insgesamt 109 Milliarden Parametern und 16 Experten. Das bedeutet, Maverick ist das umfangreichere Modell der beiden.

In einen Vergleich mit Wettbewerbern wie Googles Gemini 2.0 Flash, GPT-4o und DeepSeek v3.1 kann sich Maverick entweder an die Spitze setzen oder ist diesen sehr nahe. Im Gegensatz dazu konkurriert Llama 4 Scout mit kleineren Modellen wie Gemma 3 27B, Mistral 3.1 24B und Gemini 2.0 Flash Lite, die darauf ausgelegt sind, lokal auf Systemen betrieben zu werden. Auch hier zeigt Scout hervorragende Leistungen bei den Benchmarks.

Das Geheimnis der Effizienz: Mixture of Experts

Die Effizienz dieser neuen Modelle basiert auf dem sogenannten Mixture-of-Experts-Ansatz (MoE). Bei diesem Konzept ist das Modell aus mehreren kleineren Modellen zusammengesetzt, und die Routing-Experten bestimmen, welcher Teil aktiv ist, wenn ein Token verarbeitet wird. Bei einer Anfrage sind aus 400 Milliarden Parametern nur 17 Milliarden aktiv, was die Rechenkapazität drastisch reduziert und die Verarbeitungsgeschwindigkeit erhöht. So kann Llama 4 Maverick auf einer einzelnen Nvidia H100 DGX und Llama 4 Scout auf einer grundlegenden Nvidia H100 GPU betrieben werden.

Ein kostspieliges Experiment: DeepSeek

Interessanterweise verfolgt Meta mit seinen neuen Modellen einen Ansatz, der dem von DeepSeek ähnelt. Das chinesische Start-up hatte zuvor für Aufsehen gesorgt, da dessen Modell weitaus weniger Rechenkapazitäten als vergleichbare Modelle von OpenAI oder Google erforderte.

Beide Llama-4-Modelle haben von Llama 4 Behemoth profitiert, dem bisher größten Modell von Meta, das über 288 Milliarden aktive Parameter und insgesamt über 2 Billionen Parameter verfügt. Dieses Modell befindet sich jedoch noch im Preview-Status, und Meta arbeitet derzeit an der finalen Version, die voraussichtlich die Leistungsgrenzen von GPT-4.5, Claude Sonnet 3.7 und Gemini 2.0 Pro übertreffen wird.

Das Training von Maverick und Scout erfolgte durch Destillation, bei der das große Modell Behemoth kleinere Modelle anleitet und diese die gelernten Antworten nachahmen – ein cleverer Weg zur Wissensübertragung.

Einschränkungen für EU-Nutzer

Die Llama-4-Modelle sind über Llama.com und Hugging Face verfügbar. Meta verfolgt dabei einen offenen Quellansatz, jedoch mit Einschränkungen für Dienste mit mehr als 700 Millionen Nutzern, die eine Genehmigung von Meta benötigen. Besonders bedenklich: Firmen und Einzelpersonen mit Sitz in der EU dürfen die Modelle nicht nutzen, was bedeutet, dass Nutzer in dieser Region von der Technologie ausgeschlossen sind. Dieses Verbot betrifft allerdings nicht die Endnutzer von Produkten oder Diensten, die Llama-Modelle integriert haben.

Zusätzlich integriert Meta die Llama-4-Modelle in seine Meta AI, die nun in sozialen Netzwerken wie Facebook und Instagram sowie auch in WhatsApp zur Verfügung steht. Doch auch hier ist die Zugriffsmöglichkeit in der EU eingeschränkt.

Brasil (PT)

Brasil (PT)

Canada (EN)

Canada (EN)

Chile (ES)

Chile (ES)

Česko (CS)

Česko (CS)

대한민국 (KO)

대한민국 (KO)

España (ES)

España (ES)

France (FR)

France (FR)

Hong Kong (EN)

Hong Kong (EN)

Italia (IT)

Italia (IT)

日本 (JA)

日本 (JA)

Magyarország (HU)

Magyarország (HU)

Norge (NO)

Norge (NO)

Polska (PL)

Polska (PL)

Schweiz (DE)

Schweiz (DE)

Singapore (EN)

Singapore (EN)

Sverige (SV)

Sverige (SV)

Suomi (FI)

Suomi (FI)

Türkiye (TR)

Türkiye (TR)

الإمارات العربية المتحدة (AR)

الإمارات العربية المتحدة (AR)