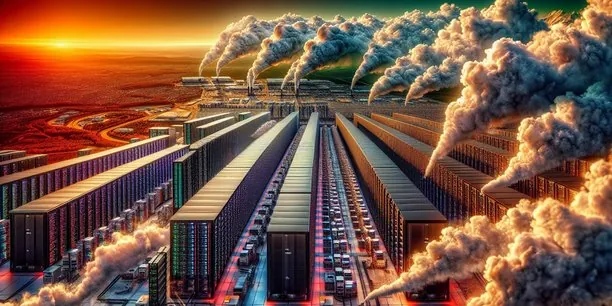

Intelligence artificielle : un désastre environnemental imminent

2024-11-14

Auteur: Chloé

Peut-on vraiment continuer de pousser les limites de l'intelligence artificielle sans compromettre la santé de notre planète ? Au cours des dernières semaines, de nombreux experts ont lancé des alertes alarmantes. OpenAI, le créateur de ChatGPT, a récemment informé la Maison Blanche qu'un seul de ses nouveaux centres de données pourrait nécessiter plus d'énergie que toute une ville.

Pour ajouter à cette inquiétude, Constellation Energy et Microsoft ont signé un contrat de vingt ans pour relancer la centrale nucléaire de Three Mile Island en Pennsylvanie, tristement célèbre pour son accident nucléaire en 1979. De son côté, Google a fait état de ses difficultés à atteindre la neutralité carbone, un objectif jugé crucial par de nombreux écologistes.

Un dossier de BloombergNEF souligne même que les Etats-Unis, qui abritent la majorité des grandes entreprises d'IA, pourraient bien voir leurs avancées en matière de décarbonisation se ralentir. Selon leurs projections, les émissions de gaz à effet de serre ne seraient réduites que de 34 % d'ici 2030, bien loin de l'objectif de 50 à 52 % fixé par les accords de Paris. La raison : l'avidité énergétique de l'IA.

La démocratisation rapide de l'IA

Tristan Nitot, directeur associé chez OCTO Technology, rappelle que tous les géants du web privilégient désormais la performance des modèles d'IA au détriment de leur coût énergétique : « Cette direction prise pourrait bien avoir des conséquences désastreuses. » Éric Schmidt, l’ancien patron de Google, a souligné à une conférence qu’il doute que nous atteignions nos objectifs environnementaux en raison de la nature énergivore de l'IA.

Cette démocratisation de l'IA, déjà intégrée dans de nombreux produits grand public, soulève des questions cruciales. Par exemple, la dernière version d'iOS est désormais équipée d'une fonctionnalité nommée « Apple Intelligence » qui résume vos notifications. De plus, les outils comme AI Overviews de Google, offrent des synthèses alimentées par l'IA, rendant la technologie accessible au plus grand nombre. L'Agence internationale de l'énergie (AIE) a même rapporté qu'une seule requête sur ChatGPT consommerait presque dix fois plus d’électricité qu’une recherche basique sur Google.

L’impact devastateur de l’entraînement des IA

Mais le véritable coût énergétique se cache également dans les phases d'entraînement des modèles d'IA. En effet, ces systèmes doivent ingérer d’immenses quantités de données au cours de processus qui peuvent prendre des jours, voire des semaines, nécessitant des ressources considérables. La majorité des infrastructures de données se situent dans des régions où l'énergie demeure fortement carbonée, comme les États-Unis, l'Irlande ou l’Allemagne.

En outre, il est essentiel de comprendre que la consommation d'eau est également une préoccupation majeure. Les data centers, confrontés à une surchauffe, utilisent des systèmes de refroidissement très gourmands en eau. Microsoft a vu sa consommation d'eau augmenter de 33 % par rapport à 2021, tandis que Google a enregistré une hausse de 21 %. Pour Tristan Nitot, il est impératif de considérer le cycle de vie complet de l'IA, depuis l'extraction des métaux rares jusqu'à leur transport pour la fabrication des processeurs, souvent produit à Taïwan.

Des solutions technologiques en cours

Face à ces défis, des efforts existent. Nvidia, par exemple, prétend améliorer continuellement l’efficacité énergétique de ses unités de traitement graphique (GPU) utilisées pour l'entraînement des IA. Les data centers adoptent également des innovations dans le refroidissement, comme la technique de « direct cooling », qui utilise moins d'eau et d’électricité.

Cependant, certains spécialistes émettent des réserves. Gaël Varoquaux de l'Inria rappelle que malgré ces avancées, nous n’avons jamais consommé autant de charbon. Il se demande si l'IA pourra échapper au paradoxe de Jevons, qui suggère qu'en améliorant l'efficacité des ressources, leur consommation totale augmente au lieu de diminuer.

Une lueur d'espoir existe dans le développement de modèles plus petits, capables de fonctionner avec jusqu'à dix fois moins de puissance de calcul, et qui peuvent être déployés sur des appareils classiques comme des smartphones. Mais au-delà des avancées techniques, un changement de mentalité est capital. Gilles Babinet, président du Conseil national du numérique, plaide pour un frein sur la mise à jour incessante des modèles et l'adoption d’IA plus ciblées.

Une éducation indispensable

Malheureusement, l'usage excessif d'applications d'IA générative dans divers contextes a déjà pris racine dans nos vies. Pierre-Yves Oudeyer, directeur de recherche à l'Inria, a noté que beaucoup de jeunes se tournent vers l'IA pour des informations simples, rappelant le vieux cliché de « prendre un bulldozer pour écraser une mouche ». Pour lui, éduquer les utilisateurs sur les conséquences environnementales de leurs interactions avec l'IA est crucial. Alors que la honte d'utiliser des moyens polluants comme l'avion émerge, cette prise de conscience devra aussi s’étendre aux simples requêtes posées à ChatGPT.

Brasil (PT)

Brasil (PT)

Canada (EN)

Canada (EN)

Chile (ES)

Chile (ES)

Česko (CS)

Česko (CS)

대한민국 (KO)

대한민국 (KO)

España (ES)

España (ES)

France (FR)

France (FR)

Hong Kong (EN)

Hong Kong (EN)

Italia (IT)

Italia (IT)

日本 (JA)

日本 (JA)

Magyarország (HU)

Magyarország (HU)

Norge (NO)

Norge (NO)

Polska (PL)

Polska (PL)

Schweiz (DE)

Schweiz (DE)

Singapore (EN)

Singapore (EN)

Sverige (SV)

Sverige (SV)

Suomi (FI)

Suomi (FI)

Türkiye (TR)

Türkiye (TR)

الإمارات العربية المتحدة (AR)

الإمارات العربية المتحدة (AR)